MONACO DI BAVIERA (IT BOLTWISE) – Un nuovo approccio consente a strumenti di intelligenza artificiale come Stable Diffusion e DALL-E-3 di semplificare il processo di creazione dell'immagine in un unico passaggio, mantenendo o addirittura migliorando la qualità dell'immagine e aumentando la velocità del processo. Aumentato 30 volte. I ricercatori del MIT CSAIL hanno compiuto progressi significativi semplificando i tradizionali modelli di diffusione multifase in un unico passaggio.

Nella nostra attuale era di intelligenza artificiale, i computer possono creare “arte” da soli utilizzando modelli di diffusione che trasformano gradualmente la struttura in uno stato inizialmente rumoroso finché non emerge un’immagine o un video chiaro. Questi modelli hanno improvvisamente trovato un posto sulla tavola di tutti: scrivi poche parole e vivi istantaneamente scene da sogno all'intersezione tra realtà e fantasia, innescando una scarica di dopamina. Dietro le quinte, si tratta di un processo complesso e dispendioso in termini di tempo che richiede numerose iterazioni dell'algoritmo per migliorare l'immagine.

I ricercatori del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT hanno presentato un nuovo quadro che semplifica il processo in più fasi dei modelli di diffusione tradizionali in un unico passaggio, affrontando le limitazioni precedenti. Ciò si ottiene attraverso una sorta di modello insegnante-studente: a un nuovo modello computerizzato viene insegnato a imitare il comportamento degli archetipi più complessi che generano le immagini.

Questo approccio, noto come distillazione conforme alla distribuzione (DMD), preserva la qualità delle immagini generate e consente una generazione molto più rapida.

“Il nostro lavoro è un nuovo metodo che accelera di 30 volte i modelli di propagazione esistenti come Stable Diffusion e DALL-E-3”, afferma Tianwei Yin, uno studente laureato del MIT in ingegneria elettrica e informatica, un affiliato di CSAIL, e il ricercatore capo”. Dai framework DMD.

“Questo progresso non solo riduce significativamente il tempo di elaborazione, ma mantiene o addirittura supera la qualità del contenuto visivo generato. In teoria, questo approccio combina i principi delle reti generative avversarie (GAN) con i principi dei modelli di diffusione e raggiunge la generazione di contenuto visivo in un singolo passaggio.” – In contrasto con i 100 passaggi di ottimizzazione iterativa richiesti dagli attuali modelli di diffusione, si tratta potenzialmente di un nuovo metodo di modellazione generativa che è allo stesso tempo veloce e valido.

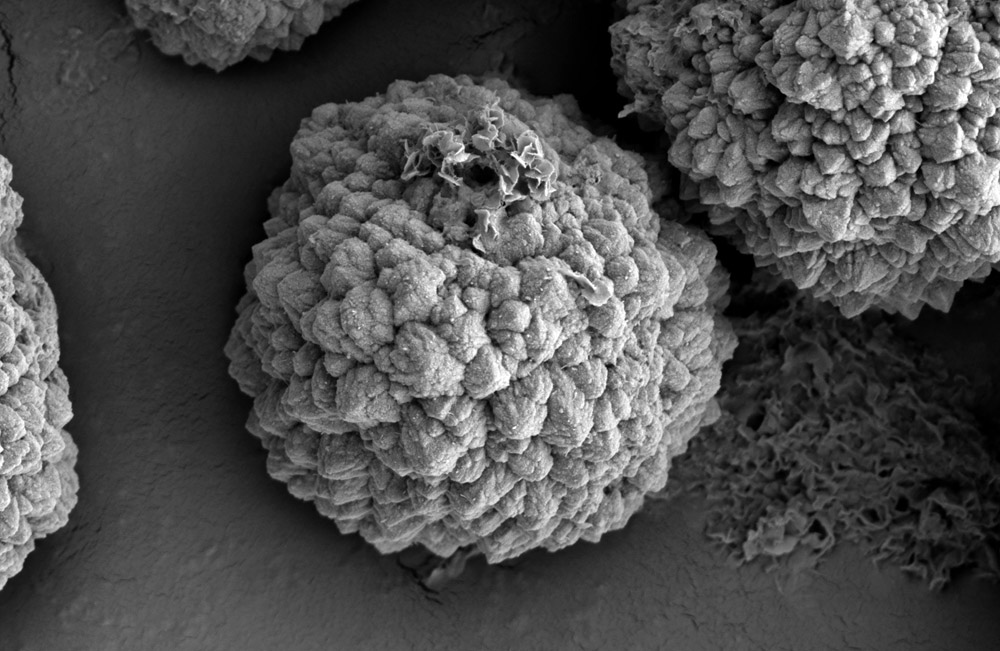

Questo modello di pubblicazione in un unico passaggio può migliorare gli strumenti di progettazione consentendo una creazione più rapida di contenuti e potenzialmente supportando i progressi nella scoperta di farmaci e nella modellazione 3D, dove velocità ed efficienza sono fondamentali.

DMD ha due componenti in modo intelligente. Innanzitutto, utilizza la perdita di regressione stabilizzatrice dell'immagine per garantire la regolarizzazione approssimativa dello spazio dell'immagine e rendere l'addestramento più stabile.

Quindi utilizza una perdita di corrispondenza della distribuzione, che garantisce che la probabilità di generare una determinata immagine utilizzando il modello Student corrisponda alla sua reale frequenza di occorrenza. Per fare ciò, utilizza due modelli di propagazione che fungono da guida e aiutano il sistema a comprendere la differenza tra immagini reali e generate, rendendo possibile un rapido addestramento del generatore in un unico passaggio.

Il sistema raggiunge una generazione più rapida addestrando una nuova rete per ridurre la differenza di distribuzione tra le immagini generate e quelle nel set di dati di addestramento utilizzato dai modelli di diffusione tradizionali. “La nostra intuizione principale è approssimare i gradienti che guidano l’ottimizzazione del nuovo modello utilizzando due modelli di diffusione”, afferma Yin.

“In questo modo, estraiamo la conoscenza dal modello originale, più complesso, in un modello più semplice e veloce, evitando i problemi di instabilità e collasso della modalità che sono noti nei GAN”.

Yin e i suoi colleghi hanno utilizzato reti pre-addestrate per il nuovo modello studentesco, semplificando il processo. Copiando e regolando i parametri dei modelli originali, il team ha ottenuto una rapida convergenza dell'addestramento del nuovo modello, in grado di produrre immagini di alta qualità con la stessa base architettonica. “Ciò consente di combinare più miglioramenti del sistema basati sull’architettura originale per accelerare ulteriormente il processo di costruzione”, aggiunge Yin.

Quando testato rispetto a metodi comuni, utilizzando un'ampia gamma di parametri, DMD ha dimostrato prestazioni costanti. Nel popolare standard per la generazione di immagini basate su classi definite su ImageNet, DMD è la prima tecnica di diffusione in un unico passaggio che produce immagini che corrispondono strettamente a quelle di archetipi più complessi, con una distanza di inizio Fréchet (FID) molto vicina di appena 0,3, che è impressionante Perché FID riguarda la valutazione della qualità e della varietà delle immagini create.

Inoltre, DMD eccelle nella generazione sintetica di testo in immagine e raggiunge le massime prestazioni nella generazione in un unico passaggio. C'è ancora un leggero divario di qualità quando si tratta di gestire difficili applicazioni di conversione testo-immagine, il che suggerisce che c'è ancora spazio per miglioramenti.

Inoltre, le prestazioni delle immagini generate da DMD sono intrinsecamente legate alle capacità del modello di caratteristiche utilizzato durante il processo di distillazione. Nel modello attuale, utilizzando Stable Diffusion v1.5 come modello insegnante, il modello studente eredita limitazioni come la visualizzazione di descrizioni dettagliate di testo e piccoli volti, il che suggerisce che modelli insegnante più avanzati possono migliorare le immagini generate da DMD.

“Ridurre il numero di iterazioni è stato il Santo Graal dei modelli di diffusione sin dal loro inizio”, afferma Fredo Durand, professore di ingegneria elettrica e informatica al MIT, ricercatore principale presso CSAIL e autore principale dello studio. “Siamo molto entusiasti di poter finalmente generare immagini in un unico passaggio, il che ridurrà significativamente i costi computazionali e accelererà il processo”.

dice Alexei Efros, professore di ingegneria elettrica e informatica all'Università della California, Berkeley, che non è stato coinvolto in questo studio. “Mi aspetto che questo lavoro apra interessanti possibilità per l'editing visivo di alta qualità e in tempo reale.”

avviso: Parti di questo testo potrebbero essere state generate utilizzando l'intelligenza artificiale.

Si prega di inviare eventuali integrazioni e informazioni alla redazione tramite email a de-info[at]it-boltwise.de

“Pensatore incurabile. Appassionato di cibo. Studioso di alcol sottilmente affascinante. Difensore della cultura pop.”

More Stories

“GTA 6” ovvero: come un gioco scuote un intero settore | Digitale

La nuova app porta questi vantaggi

Vision Pro per portatori di occhiali: le lenti da vista originali di terze parti